【编者按】2019年11月,哈佛大学伯克曼互联网与社会研究中心发布报告《内容和引导:英文维基百科如何限制有害言论》(Content and Conduct: How English Wikipedia Moderates Harmful Speech),这项研究旨在评估英文维基百科在解决有害言论问题方面的表现。该报告对维基百科的编辑人员进行了定性采访,并使用可识别多种问题言论的机器学习分类器进行了文本分析。报告提出维基百科开发了一个由志愿编辑人员和自动化工具共同组成的混合系统,可以对平台多个空间(包括文章、用户页面和文章讨论页面)上的内容进行审核,其在识别并快速删除绝大多数有害内容方面取得了巨大成功,对我国互联网内容生态治理具有参考借鉴意义。

1、在线内容管理方式和模式

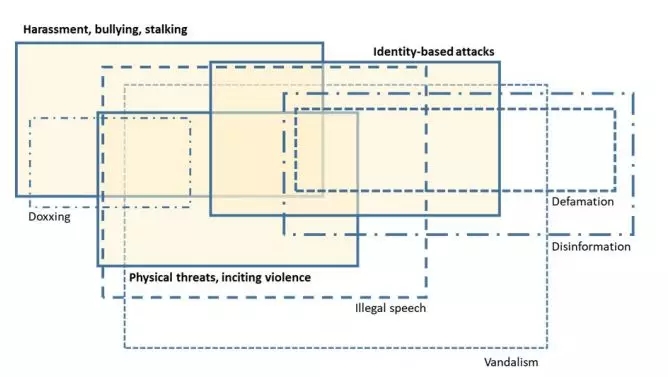

图1:本研究针对的有害重点言论形式

针对有害在线言论,首先必须有一组规则、标准、指南或原则来定义可接受和不可接受言论之间的界限。鉴于在线言论的上下文相关性和主观性,这始终是一项挑战。其次,如果要强制执行这些约束,则必须具备相应机制来发现不可接受言论。第三,必须对决定言论是否可接受的人进行责任分配。第四,必须规定和实施对不可接受言论的补救措施——相关人员/平台受到法律制裁,或者言论在私营平台上被撤下、警告或用户帐户被关停。

报告总结了部分通用模式:

1.1、法律明确规定模式

法律明确表达和规定的模式主要包括:1)“通知与删除”(N&TD),其遵循的模式是平台在收到关于内容违反法律法规的通知之前对内容不承担任何责任,收到通知后平台必须采取某种措施——无论是删除、冻结材料,或采取其他措施;2)政府发起的非法言论删除。在这种类型的模式中,针对特定的政府或法律制度认定的非法言论,政府专门机构(有时是法院)要求平台删除或强制性删除。3)优先责任。优先责任模式是指平台本身承担大量删除责任,不仅要防止某类别内容的初始发布,而且要防止后续发布,未规定任何特定的方法或术语。

1.2、共同监管和非正式合作模式

政府在内容范围和目标界定方面有实质性的参与,但形式更为非正式——删除不是法定的行为。符合此描述的两种典型模式是Google遵守美国法院有关诽谤内容的命令和英国的反恐互联网转介单位(CTIRU)。

1.3、以法律制度为基础的自律

平台内容监管的这种类型几乎完全在私营领域中运行,但是可能与其他法律要求或监管制度在概念和形式上都有联系。谷歌根据法院命令对认定的诽谤内容进行删除,可被归为这一类——因为这是谷歌内部决定。

1.4、平台自律

在纯粹的自我调节模式中,平台会根据其特定的内部需求和限制来监视和删除内容。平台甚至可能会删除完全合法的内容,这通常取决于“想成为哪种平台”或打算服务的受众类型。内容通常在没有任何压力或政府实体参与或不依赖法律框架的情况下被删除、修改或保留。

2、维基百科如何限制有害言论

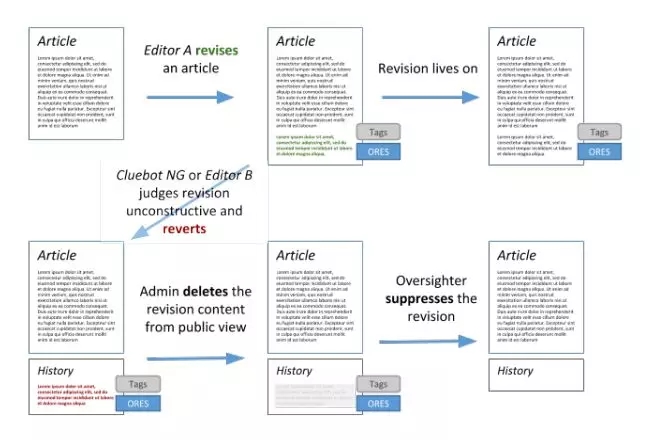

图2:维基百科上的文章修订和内容删除流程示意

要了解维基百科上有害言论的普遍性和形式,重要的是要认识到维基百科由几个不同的平行机制组成。针对维基百科文章的治理结构和标准不同于治理文章讨论页面、用户页面和用户讨论页面。与讨论页面相比,维基百科的文章受到了破坏者的负面关注。

维基百科开发了一个由志愿编辑人员和自动化工具组成的混合系统,对平台的多个空间(包括文章、用户页面和文章讨论页面)上的内容进行审核。第一道防线是评估和删除有害内容的自动化工具,包括机器人、自动应用标签和目标修订评估服务(ORES)。数千种机器人中,在内容清除上最为突出的是ClueBot NG。第二代ClueBot NG使用了一组机器学习算法复原了数百万次编辑。

MediaWiki平台上应用的是ORES。与ClueBot NG一样,该服务使用机器学习功能进行打分,打分的依据是内容是否对平台造成破坏以及是否出于善意,编辑人员可据此优先考虑修订内容。通过提供“编辑过滤器”的AbuseFilter扩展程序,编辑人员可以锁定破坏行为并做出反应。编辑过滤器基于人工编码而非机器学习,如果修订符合某些条件,则执行相应操作。

第二道防线是维基百科的编辑人员。维基百科上有许多不同的用户权限。每个用户对高级工具的访问权限不同,在平台上担任不同的角色。编辑是编写或修改维基百科或以其他方式对该平台做出贡献的任何人。管理员是被授予高级技术权限的编辑者,因此他们可以删除、冻结或解冻注册用户账号,删除和保护页面以防编辑以及授予用户特殊的权限。监督者是由36位编辑者组成的小组,具有更高的权限。用户检查员是由40位编辑者组成的小组,可以使用高级工具来确定维基百科帐户的IP地址——为了调查和防止破坏性编辑或用户使用马甲等情况的出现。

实际上,维基百科同时运行多种监管制度,这些制度采用不同的工具集并具有不同的目标。其中一种制度旨在指导其志愿编辑人员创建和维护百科全书。另一种则旨在调解编辑工作时的人际关系。两者均基于一套详细的指导方针和政策来运作,这些指导方针和政策是多年以来的社会规范的反映,这些规范通过去中心化的实施方式,在应用中提高了其灵活性和自主判断性。

3、结论

尽管维基百科面临大规模和高开放等挑战,但维基百科在快速识别和删除平台上文章中的有害内容方面非常有效。自动化工具与志愿编辑时的警惕性相辅相成,消除了故意破坏者试图引入的有害言论。

去中心的结构使编辑者可以迅速而果断地解释何种内容对维基百科构成损害和伤害。相较于某些社交媒体平台致力于明确阐明何种言论可以接受的方式,维基百科并没有此类简要阐述,而是赋予个人对内容的判断权。这自然会导致人们在解释和实施维基百科的指南和政策上产生分歧,但内容的自主决策所带来的好处和敏捷性可以与之相抵消。受访者普遍认为,应用过程中标准不一致只是相对较小的代价,执行更加清晰明了的规则将是重中之重。

对于维基百科而言,更加困难和持续的挑战是减轻和解决社群本身互动中的危害,以及减少针对维基百科编辑而非文章的攻击。这个问题的根源与维基百科的核心使命和协作开放性质息息相关。与知识生产过程中相互合作一样艰巨的任务是培育能够和睦相处的社群——能够协商哪些贡献可保留,哪些修改需移除。维基百科的持续生命力在于维护一个获得授权并做出承诺的社群,而社群的作用又在于建立并维持合规的言论环境,阻止违反社会规范的内容发布。

维基百科在监管其内容方面的相对成功与其他大型商业平台(Facebook,Twitter和YouTube)所处的抗争阶段形成了鲜明对比,这些平台使用自动化工具、社群标记和带薪审核者的组合来监视其平台。而维基百科采用的方法和策略为其他依赖社区的在线平台提供了宝贵的经验教训,但是由于去中心的决策机制和维基百科新兴规范限制了这些方法和教训在其他商业平台的可移植性,维基百科使用的社群相关方法无法直接转化应用在商业平台上。

编译 | 贺佳瀛/赛博研究院研究员

本文由赛博研究院出品,转载请注明:本文来源于赛博研究院公众号。

更多精彩内容请关注“赛博研究院”公众号。